เครื่องตรวจจับที่ขับเคลื่อนด้วย AI เป็นเครื่องมือที่ดีที่สุดในการตรวจจับวิดีโอปลอมที่สร้างโดย AI เดอะวอชิงตันโพสต์ผ่านเก็ตตี้อิมเมจ

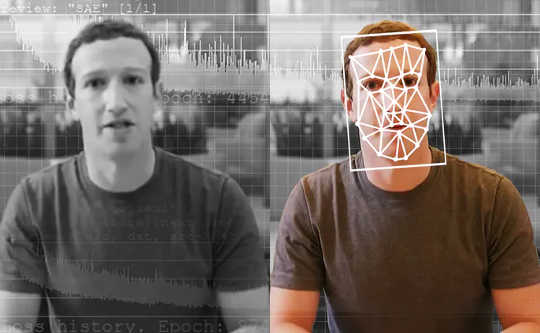

นักข่าวสืบสวนได้รับวิดีโอจากผู้แจ้งเบาะแสที่ไม่เปิดเผยตัว แสดงให้เห็นผู้สมัครประธานาธิบดียอมรับกิจกรรมที่ผิดกฎหมาย แต่วิดีโอนี้เป็นของจริงหรือ หากเป็นเช่นนั้น มันจะเป็นข่าวใหญ่ – เรื่องราวครั้งหนึ่งในชีวิต – และสามารถพลิกโฉมการเลือกตั้งที่จะเกิดขึ้นได้อย่างสมบูรณ์ แต่นักข่าวดำเนินการวิดีโอโดยใช้เครื่องมือพิเศษ ซึ่งบอกเธอว่าวิดีโอนั้นไม่ใช่อย่างที่เห็น อันที่จริงมันเป็น “deepfake” วิดีโอที่สร้างโดยใช้ปัญญาประดิษฐ์กับ การเรียนรู้ลึก ๆ.

นักข่าวทั่วโลกสามารถใช้เครื่องมือแบบนี้ได้ในไม่ช้า ในอีกไม่กี่ปีข้างหน้า ทุกคนสามารถใช้เครื่องมือแบบนี้เพื่อขจัดเนื้อหาปลอมในฟีดโซเชียลมีเดียของตนได้

As นักวิจัย ที่กำลังศึกษาการตรวจหา deepfake อยู่ และพัฒนาเครื่องมือสำหรับนักข่าว เราเห็นอนาคตของเครื่องมือเหล่านี้ พวกเขาจะไม่แก้ปัญหาของเราทั้งหมด และพวกเขาจะเป็นเพียงส่วนหนึ่งของคลังแสงในการต่อสู้กับการบิดเบือนข้อมูลในวงกว้าง

ปัญหาเกี่ยวกับ Deepfakes

คนส่วนใหญ่รู้ว่าคุณไม่สามารถเชื่อทุกอย่างที่คุณเห็น ในช่วงสองสามทศวรรษที่ผ่านมา ผู้บริโภคข่าวที่ชาญฉลาดได้คุ้นเคยกับการเห็นภาพที่ปรับแต่งด้วยซอฟต์แวร์แก้ไขภาพ แม้ว่าวิดีโอจะเป็นอีกเรื่องหนึ่ง ผู้กำกับฮอลลีวูดสามารถใช้เงินหลายล้านดอลลาร์ไปกับเอฟเฟกต์พิเศษเพื่อสร้างฉากที่สมจริง แต่การใช้ deepfakes นั้น นักเล่นมือสมัครเล่นที่มีอุปกรณ์คอมพิวเตอร์ราคาไม่กี่พันดอลลาร์และใช้เวลาเพียงไม่กี่สัปดาห์ก็สามารถสร้างบางสิ่งที่เกือบจะเหมือนกับชีวิตจริงได้

Deepfakes ทำให้สามารถนำผู้คนเข้าสู่ฉากภาพยนตร์ที่พวกเขาไม่เคยอยู่ในนั้นได้ – นึกว่าทอม ครูซ เล่นไอรอนแมน - ซึ่งทำให้วิดีโอความบันเทิง น่าเสียดายที่มันยังทำให้สามารถสร้าง ภาพอนาจารโดยไม่ได้รับความยินยอม ของผู้คนที่ปรากฎ จนถึงตอนนี้ คนเหล่านั้น ซึ่งเป็นผู้หญิงเกือบทุกคน เป็นเหยื่อที่ใหญ่ที่สุดเมื่อมีการใช้เทคโนโลยี Deepfake ในทางที่ผิด

Deepfakes ยังใช้สร้างวิดีโอของผู้นำทางการเมืองที่พูดในสิ่งที่พวกเขาไม่เคยพูดได้ พรรคสังคมนิยมเบลเยี่ยมเปิดตัววิดีโอปลอมที่มีคุณภาพต่ำแต่ยังหลอกลวง ปธน.ทรัมป์ดูหมิ่นเบลเยียมซึ่งมีปฏิกิริยาเพียงพอที่จะแสดงความเสี่ยงที่อาจเกิดขึ้นจาก Deepfakes ที่มีคุณภาพสูงกว่า

{ชื่อ Y=poSd2CyDpyA}

Hany Farid จากมหาวิทยาลัยแห่งแคลิฟอร์เนีย Berkeley อธิบายว่า Deepfakes ถูกสร้างขึ้นมาอย่างไร

บางที น่ากลัวที่สุด, สามารถนำมาใช้เพื่อสร้าง สงสัยเกี่ยวกับเนื้อหาของวิดีโอจริงโดยบอกว่าพวกเขาอาจเป็นของปลอมได้

เมื่อพิจารณาถึงความเสี่ยงเหล่านี้แล้ว การตรวจพบ Deepfake และติดฉลากไว้อย่างชัดเจนจะเป็นประโยชน์อย่างยิ่ง เพื่อให้แน่ใจว่าวิดีโอปลอมจะไม่หลอกลวงประชาชน และวิดีโอจริงสามารถรับได้เหมือนของจริง

ตรวจจับของปลอม

การตรวจจับ Deepfake เมื่อการวิจัยเริ่มขึ้นเล็กน้อย สามปีที่ผ่านมา. งานแรกเน้นการตรวจจับปัญหาที่มองเห็นได้ในวิดีโอ เช่น ของปลอมที่ไม่กระพริบตา. อย่างไรก็ตามเมื่อเวลาผ่านไป ของปลอมดีขึ้นแล้ว ในการเลียนแบบวิดีโอจริงและยากต่อการมองเห็นสำหรับทั้งผู้คนและเครื่องมือตรวจจับ

การวิจัยการตรวจจับ Deepfake มีสองประเภทหลัก ครั้งแรกเกี่ยวข้องกับ มองดูพฤติกรรมคน ในวิดีโอ สมมติว่าคุณมีวิดีโอของบุคคลที่มีชื่อเสียงมากมาย เช่น ประธานาธิบดีโอบามา ปัญญาประดิษฐ์สามารถใช้วิดีโอนี้เพื่อเรียนรู้รูปแบบของเขา ตั้งแต่ท่าทางมือไปจนถึงการหยุดพูด ได้แล้ว ดูลึกล้ำของเขา และสังเกตว่ามันไม่ตรงกับรูปแบบเหล่านั้น แนวทางนี้มีข้อได้เปรียบที่อาจใช้งานได้แม้ว่าคุณภาพของวิดีโอจะสมบูรณ์แบบก็ตาม

{ชื่อ Y=gsv1OsCEad0}

Aaron Lawson ของ SRI International อธิบายแนวทางหนึ่งในการตรวจจับ Deepfakes

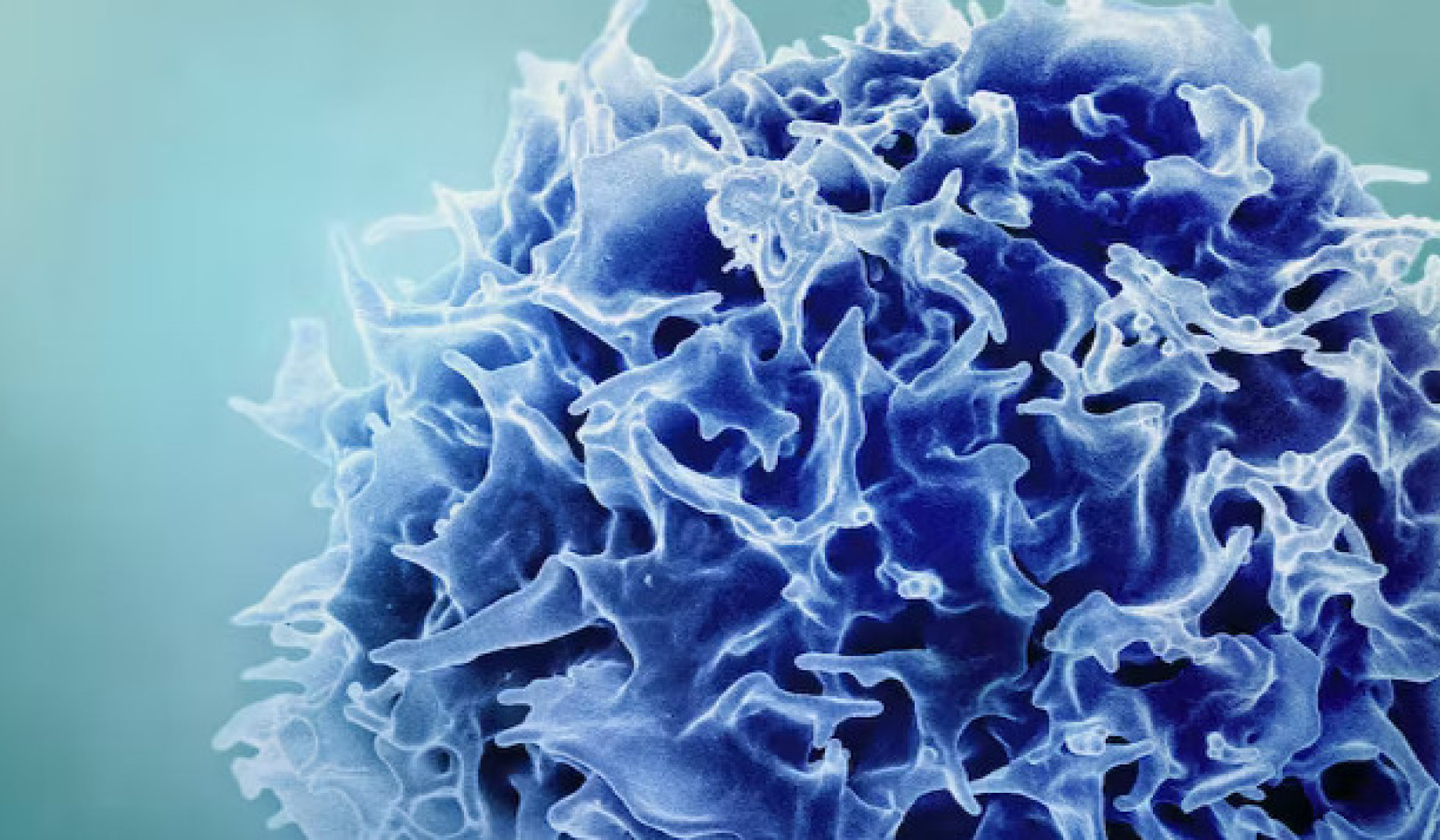

นักวิจัยอื่นๆ รวมทั้งทีมงานของเราด้วยได้รับการมุ่งเน้นไปที่ ความแตกต่าง ที่ deepfakes ทั้งหมดมี เมื่อเทียบกับวิดีโอจริง วิดีโอ Deepfake มักถูกสร้างขึ้นโดยการรวมเฟรมที่สร้างขึ้นทีละรายการเพื่อสร้างวิดีโอ เมื่อคำนึงถึงสิ่งนี้ วิธีการของทีมของเราดึงข้อมูลที่จำเป็นออกจากใบหน้าในแต่ละเฟรมของวิดีโอ แล้วติดตามผ่านชุดเฟรมพร้อมกัน ซึ่งช่วยให้เราตรวจพบความไม่สอดคล้องกันในการไหลของข้อมูลจากเฟรมหนึ่งไปยังอีกเฟรมหนึ่ง เราใช้แนวทางที่คล้ายกันสำหรับระบบตรวจจับเสียงปลอมของเราเช่นกัน

รายละเอียดเล็กๆ น้อยๆ เหล่านี้ยากต่อการมองเห็น แต่แสดงให้เห็นว่าของปลอมนั้นไม่ได้ล้ำลึกเพียงใด ยังสมบูรณ์แบบ. เครื่องตรวจจับแบบนี้สามารถใช้ได้กับทุกคน ไม่ใช่แค่ผู้นำระดับโลกเพียงไม่กี่คน ในท้ายที่สุดอาจจำเป็นต้องใช้เครื่องตรวจจับ Deepfake ทั้งสองประเภท

ระบบตรวจจับล่าสุดทำงานได้ดีมากกับวิดีโอที่รวบรวมมาโดยเฉพาะเพื่อประเมินเครื่องมือ น่าเสียดายที่แม้แต่รุ่นที่ดีที่สุดก็ยังทำ ไม่ดีในวิดีโอที่พบออนไลน์. การปรับปรุงเครื่องมือเหล่านี้ให้มีประสิทธิภาพและมีประโยชน์มากขึ้นเป็นขั้นตอนต่อไปที่สำคัญ

ใครควรใช้เครื่องตรวจจับ Deepfake?

ตามหลักการแล้วทุกคนควรมีเครื่องมือตรวจสอบ Deepfake อย่างไรก็ตาม เทคโนโลยีนี้อยู่ในขั้นเริ่มต้นของการพัฒนา นักวิจัยจำเป็นต้องปรับปรุงเครื่องมือและปกป้องพวกเขาจากแฮกเกอร์ก่อนที่จะเผยแพร่ในวงกว้าง

ในขณะเดียวกัน เครื่องมือในการสร้าง Deepfakes นั้นมีให้สำหรับทุกคนที่ต้องการหลอกคนทั่วไป การนั่งข้างสนามไม่ใช่ทางเลือก สำหรับทีมของเรา ความสมดุลที่เหมาะสมคือการทำงานร่วมกับนักข่าว เนื่องจากพวกเขาเป็นแนวป้องกันแรกต่อการแพร่กระจายของข้อมูลที่ผิด

ก่อนเผยแพร่เรื่องราว นักข่าวจำเป็นต้องตรวจสอบข้อมูลก่อน พวกเขามีวิธีการที่พิสูจน์แล้วและเป็นจริงแล้ว เช่น การตรวจสอบกับแหล่งข้อมูลและการให้บุคคลมากกว่าหนึ่งคนมาตรวจสอบข้อเท็จจริงที่สำคัญ ดังนั้น การนำเครื่องมือไปใช้กับพวกเขา เราจะให้ข้อมูลเพิ่มเติมแก่พวกเขา และเรารู้ว่าพวกเขาจะไม่พึ่งพาเทคโนโลยีเพียงอย่างเดียว เนื่องจากอาจทำผิดพลาดได้

เครื่องตรวจจับสามารถชนะการแข่งขันอาวุธได้หรือไม่?

เป็นกำลังใจที่ได้เห็นทีมจาก Facebook และ ไมโครซอฟท์ ลงทุนในเทคโนโลยีเพื่อทำความเข้าใจและตรวจจับ Deepfakes สาขานี้ต้องการการวิจัยเพิ่มเติมเพื่อให้ทันกับความเร็วของความก้าวหน้าในเทคโนโลยี Deepfake

นักข่าวและแพลตฟอร์มโซเชียลมีเดียยังต้องค้นหาวิธีที่ดีที่สุดในการเตือนผู้คนเกี่ยวกับ Deepfakes เมื่อตรวจพบ จากการวิจัยพบว่า คนจำเรื่องโกหกได้แต่ไม่ใช่ความจริงที่ว่ามันเป็นเรื่องโกหก เช่นเดียวกันจะเป็นจริงสำหรับวิดีโอปลอมหรือไม่ การใส่คำว่า “Deepfake” ไว้ในชื่อเรื่องอาจไม่เพียงพอที่จะตอบโต้การบิดเบือนข้อมูลบางประเภท

Deepfakes อยู่ที่นี่เพื่ออยู่ การจัดการการบิดเบือนข้อมูลและการปกป้องสาธารณะจะมีความท้าทายมากขึ้นกว่าเดิม เนื่องจากปัญญาประดิษฐ์มีประสิทธิภาพมากขึ้น เราเป็นส่วนหนึ่งของชุมชนการวิจัยที่กำลังเติบโตซึ่งกำลังเผชิญกับภัยคุกคามนี้ ซึ่งการตรวจจับเป็นเพียงขั้นตอนแรก![]()

เกี่ยวกับผู้เขียน

John Sohrawardi นักศึกษาปริญญาเอกสาขาคอมพิวเตอร์และสารสนเทศศาสตร์ Rochester Institute of Technology และแมทธิว ไรท์ ศาสตราจารย์ด้านความปลอดภัยคอมพิวเตอร์ Rochester Institute of Technology

บทความนี้ตีพิมพ์ซ้ำจาก สนทนา ภายใต้ใบอนุญาตครีเอทีฟคอมมอนส์ อ่าน เป็นต้นฉบับ บทความ.