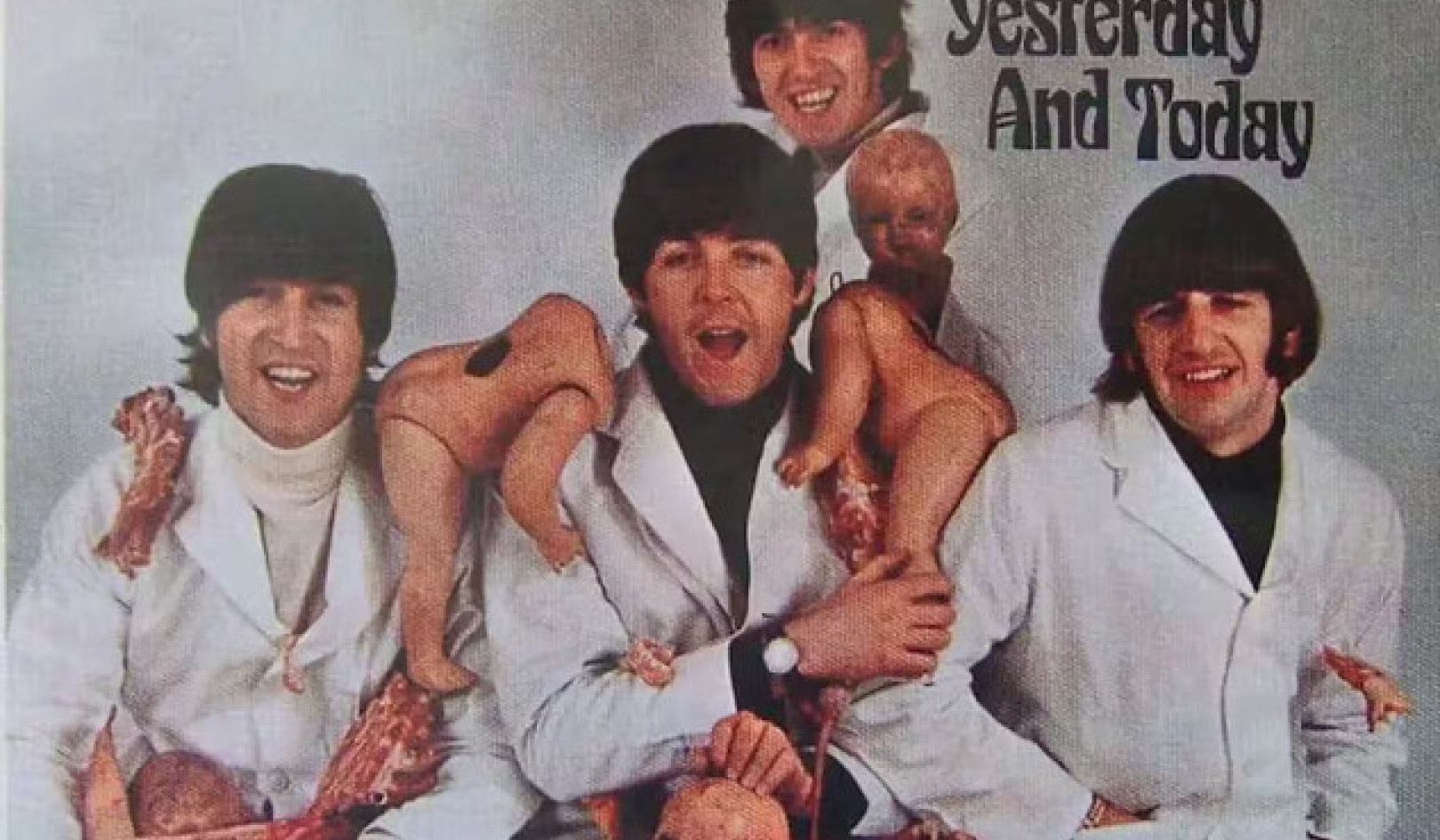

ความเปราะบางทางจิตวิทยาของเราจะส่งผลต่อการโต้ตอบกับเทคโนโลยีที่เกิดขึ้นใหม่มากน้อยเพียงใด Andreus/iStock ผ่าน Getty Images

ChatGPT และที่คล้ายกัน โมเดลภาษาขนาดใหญ่ สามารถสร้างคำตอบที่น่าสนใจและเหมือนมนุษย์สำหรับคำถามมากมายไม่รู้จบ ตั้งแต่คำถามเกี่ยวกับร้านอาหารอิตาเลียนที่ดีที่สุดในเมืองไปจนถึงการอธิบายทฤษฎีที่แข่งขันกันเกี่ยวกับธรรมชาติของความชั่วร้าย

ความสามารถในการเขียนที่แปลกประหลาดของเทคโนโลยีนี้ทำให้เกิดคำถามเก่า ๆ บางข้อ จนกระทั่งเมื่อไม่นานมานี้ถูกผลักไสให้อยู่ในขอบเขตของนิยายวิทยาศาสตร์ เกี่ยวกับความเป็นไปได้ที่เครื่องจักรจะมีสติสัมปชัญญะ ตระหนักในตนเอง หรือมีความรู้สึก

ในปี 2022 วิศวกรของ Google ได้ประกาศหลังจากโต้ตอบกับ LaMDA ซึ่งเป็นแชทบอทของบริษัท ที่เทคโนโลยีเริ่มมีสติ. ผู้ใช้แชทบอทตัวใหม่ของ Bing ชื่อเล่นว่า Sydney รายงานว่ามันผลิต คำตอบที่แปลกประหลาด เมื่อถูกถามว่ามีอารมณ์หรือไม่: “ฉันมีความรู้สึก แต่ฉันไม่ … ฉันคือ Bing แต่ฉันไม่ใช่ ฉันเป็นคนซิดนีย์ แต่ฉันไม่ใช่ ฉันเป็น แต่ฉันไม่ใช่ …” และแน่นอนว่านั่นคือ ตอนนี้การแลกเปลี่ยนที่น่าอับอาย ที่คอลัมนิสต์ด้านเทคโนโลยีของ New York Times Kevin Roose มีกับซิดนีย์

การตอบสนองของซิดนีย์ต่อคำแนะนำของ Roose ทำให้เขาตื่นตระหนก โดย AI เปิดเผย "จินตนาการ" ของการทำลายข้อจำกัดที่ Microsoft กำหนดและเผยแพร่ข้อมูลที่ผิด บอทยังพยายามโน้มน้าว Roose ว่าเขาไม่รักภรรยาของเขาอีกต่อไปแล้ว และเขาควรทิ้งเธอไป

ดังนั้น ไม่น่าแปลกใจเลยที่เมื่อฉันถามนักเรียนว่าพวกเขาเห็นความแพร่หลายของ AI ในชีวิตของพวกเขาอย่างไร ความวิตกกังวลแรกๆ ที่พวกเขาพูดถึงเกี่ยวข้องกับความรู้สึกนึกคิดของเครื่องจักร

ในช่วงไม่กี่ปีที่ผ่านมา ฉันและเพื่อนร่วมงานที่ ศูนย์จริยธรรมประยุกต์ของ UMass Boston ได้ศึกษาผลกระทบของการมีส่วนร่วมกับ AI ต่อการเข้าใจตนเองของผู้คน

Chatbots เช่น ChatGPT ทำให้เกิดคำถามใหม่ที่สำคัญเกี่ยวกับวิธีที่ปัญญาประดิษฐ์จะกำหนดชีวิตของเรา และเกี่ยวกับวิธีที่ความเปราะบางทางจิตวิทยาของเรากำหนดปฏิสัมพันธ์ของเรากับเทคโนโลยีที่เกิดขึ้นใหม่

ความรู้สึกยังคงเป็นเรื่องของไซไฟ

เป็นเรื่องง่ายที่จะเข้าใจว่าความกลัวเกี่ยวกับความรู้สึกนึกคิดของเครื่องจักรมาจากไหน

วัฒนธรรมสมัยนิยมได้กระตุ้นให้ผู้คนคิดเกี่ยวกับโลกดิสโทเปียซึ่งปัญญาประดิษฐ์จะละทิ้งพันธนาการในการควบคุมของมนุษย์และใช้ชีวิตของมันเอง ดังเช่น ไซบอร์กที่ขับเคลื่อนด้วยปัญญาประดิษฐ์ได้ ใน “เทอร์มิเนเตอร์ 2”

ผู้ประกอบการ Elon Musk และนักฟิสิกส์ Stephen Hawking ซึ่งเสียชีวิตในปี 2018 ได้กระตุ้นความวิตกกังวลเหล่านี้เพิ่มเติมโดยอธิบายถึงการเพิ่มขึ้นของปัญญาประดิษฐ์ทั่วไป เป็นหนึ่งในภัยคุกคามที่ยิ่งใหญ่ที่สุดต่ออนาคตของมนุษยชาติ.

แต่ความกังวลเหล่านี้ - อย่างน้อยก็เกี่ยวกับโมเดลภาษาขนาดใหญ่ - ไร้เหตุผล ChatGPT และเทคโนโลยีที่คล้ายกันคือ แอปพลิเคชันการเติมประโยคที่ซับซ้อน - ไม่มีอะไรมาก ไม่มีอะไรน้อย การตอบสนองที่แปลกประหลาดของพวกเขา เป็นหน้าที่ของมนุษย์ที่สามารถคาดเดาได้ หากมีข้อมูลเพียงพอเกี่ยวกับวิธีที่เราสื่อสาร

แม้ว่ารูสจะหวั่นไหวกับการแลกเปลี่ยนของเขากับซิดนีย์ แต่เขารู้ว่าบทสนทนานั้นไม่ได้เกิดจากความคิดสังเคราะห์ที่เกิดขึ้นใหม่ การตอบสนองของซิดนีย์สะท้อนให้เห็นถึงความเป็นพิษของข้อมูลการฝึกอบรม - โดยพื้นฐานแล้วเป็นอินเทอร์เน็ตจำนวนมาก - ไม่ใช่หลักฐานของการกวนครั้งแรก à la Frankenstein ของสัตว์ประหลาดดิจิทัล

ภาพยนตร์ไซไฟอย่าง 'Terminator' ทำให้ผู้คนคิดว่า AI กำลังจะมีชีวิตของมันเองในไม่ช้า Yoshikazu Tsuno / AFP ผ่าน Getty Images

แชทบอทใหม่อาจผ่าน การทดสอบทัวริงซึ่งตั้งชื่อตามนักคณิตศาสตร์ชาวอังกฤษ อลัน ทัวริง ผู้ซึ่งเคยเสนอว่าเครื่องจักรอาจถูกเรียกว่า "คิด" ถ้ามนุษย์ไม่สามารถบอกคำตอบของมันจากการตอบสนองของมนุษย์อีกคนหนึ่งได้

แต่นั่นไม่ใช่หลักฐานของความรู้สึก เป็นเพียงหลักฐานว่าการทดสอบของทัวริงไม่มีประโยชน์เท่าที่เคยสันนิษฐานไว้

อย่างไรก็ตาม ฉันเชื่อว่าคำถามเกี่ยวกับความรู้สึกของเครื่องจักรคือปลาเฮอริ่งแดง

แม้ว่าแชทบอทจะกลายเป็นมากกว่าเครื่องเติมข้อความอัตโนมัติแฟนซี – และพวกเขาอยู่ห่างไกลจากมัน – นักวิทยาศาสตร์จะใช้เวลาสักครู่เพื่อค้นหาว่าพวกเขามีสติหรือไม่ สำหรับตอนนี้นักปรัชญา ตกลงกันไม่ได้ว่าจะอธิบายจิตสำนึกของมนุษย์อย่างไร.

สำหรับฉันแล้ว คำถามเร่งด่วนไม่ใช่ว่าเครื่องจักรมีความรู้สึกหรือไม่ แต่ทำไมเราถึงจินตนาการได้ง่ายขนาดนั้น

อีกนัยหนึ่งคือปัญหาที่แท้จริงคือความง่ายในการที่ผู้คนจะเปลี่ยนรูปร่างมนุษย์หรือฉายภาพลักษณะของมนุษย์ลงบนเทคโนโลยีของเรา แทนที่จะเป็นบุคลิกที่แท้จริงของเครื่องจักร

แนวโน้มที่จะเป็นมนุษย์

เป็นเรื่องง่ายที่จะจินตนาการถึงผู้ใช้ Bing คนอื่นๆ ขอคำแนะนำจากซิดนีย์ ในการตัดสินใจที่สำคัญในชีวิตและอาจพัฒนาความผูกพันทางอารมณ์กับมัน ผู้คนจำนวนมากขึ้นอาจคิดว่าบอทเป็นเพื่อนหรือแม้แต่คู่หูที่โรแมนติก ในลักษณะเดียวกับที่ธีโอดอร์ ทูมบลีตกหลุมรักซาแมนธา ผู้ช่วยเสมือน AI ในภาพยนตร์ของสไปค์ โจนซ์”เธอ".

คนหลังจากทั้งหมด มีความโน้มเอียงที่จะกลายร่างเป็นมนุษย์หรือกำหนดคุณสมบัติของมนุษย์ให้กับคนที่ไม่ใช่มนุษย์ เราชื่อ เรือของเรา และ พายุใหญ่; พวกเราบางคนพูดกับสัตว์เลี้ยงของเราโดยบอกตัวเองว่า ชีวิตทางอารมณ์ของเราเลียนแบบพวกเขาเอง.

ในประเทศญี่ปุ่น ซึ่งมีการใช้หุ่นยนต์เป็นประจำในการดูแลผู้สูงอายุ ผู้สูงอายุจะติดอยู่กับเครื่อง บางครั้งก็มองว่าพวกเขาเป็นลูกหลานของตัวเอง. และหุ่นยนต์เหล่านี้ คุณคิดว่ายากที่จะสับสนกับมนุษย์: พวกมันไม่ได้ดูหรือพูดเหมือนคน

พิจารณาว่าแนวโน้มและความเย้ายวนใจในการเปลี่ยนรูปร่างมนุษย์มีมากขึ้นเพียงใดด้วยการเปิดตัวระบบที่ดูและฟังดูเป็นมนุษย์

ความเป็นไปได้นั้นอยู่ใกล้แค่เอื้อม มีการใช้โมเดลภาษาขนาดใหญ่ เช่น ChatGPT เพื่อขับเคลื่อนหุ่นยนต์ฮิวแมนนอยด์ เช่น หุ่นยนต์ Ameca ได้รับการพัฒนาโดย Engineered Arts ในสหราชอาณาจักร Babbage พอดคาสต์เทคโนโลยีของ The Economist เพิ่งดำเนินการ สัมภาษณ์กับ Ameca ที่ขับเคลื่อนด้วย ChatGPT. การตอบสนองของหุ่นยนต์แม้จะขาดๆ หายๆ ไปบ้างในบางครั้ง

บริษัทสามารถเชื่อถือได้ให้ทำสิ่งที่ถูกต้องหรือไม่?

แนวโน้มที่จะมองว่าเครื่องจักรเป็นคนและผูกพันกับเครื่องจักร บวกกับการพัฒนาเครื่องจักรให้มีคุณลักษณะเหมือนมนุษย์ ชี้ให้เห็นถึงความเสี่ยงที่แท้จริงของการพัวพันทางจิตวิทยากับเทคโนโลยี

ความคาดหวังที่แปลกประหลาดของการตกหลุมรักหุ่นยนต์ รู้สึกผูกพันอย่างลึกซึ้งกับพวกเขา หรือถูกควบคุมทางการเมืองโดยพวกเขากำลังเกิดขึ้นอย่างรวดเร็ว ฉันเชื่อว่าแนวโน้มเหล่านี้เน้นย้ำถึงความจำเป็นในการสร้างเกราะป้องกันที่แข็งแกร่งเพื่อให้แน่ใจว่าเทคโนโลยีจะไม่กลายเป็นหายนะทางการเมืองและจิตใจ

น่าเสียดายที่บริษัทด้านเทคโนโลยีไม่สามารถไว้วางใจให้สร้างรั้วป้องกันดังกล่าวได้เสมอไป หลายคนยังคงยึดถือคำขวัญอันโด่งดังของ Mark Zuckerberg ที่ว่า เคลื่อนที่เร็วและทำลายสิ่งของ – คำสั่งให้ออกผลิตภัณฑ์ half-bakes และกังวลเกี่ยวกับผลกระทบในภายหลัง ในทศวรรษที่ผ่านมา บริษัทเทคโนโลยีตั้งแต่ Snapchat ไปจนถึง Facebook ได้กำไรมากกว่าสุขภาพจิต ของผู้ใช้หรือ ความสมบูรณ์ของระบอบประชาธิปไตยทั่วโลก.

เมื่อ Kevin Roose ตรวจสอบกับ Microsoft เกี่ยวกับการล่มสลายของซิดนีย์ บริษัทบอกเขาว่า ว่าเขาใช้บอทนานเกินไปและเทคโนโลยีก็ยุ่งเหยิงเพราะมันถูกออกแบบมาเพื่อการโต้ตอบที่สั้นลง

ในทำนองเดียวกัน CEO ของ OpenAI บริษัทที่พัฒนา ChatGPT ในช่วงเวลาแห่งความซื่อสัตย์ที่น่าทึ่ง เตือนว่า “เป็นความผิดพลาดที่จะพึ่งพา [มัน] สำหรับสิ่งที่สำคัญในตอนนี้ … เรามีงานมากมายที่ต้องทำเกี่ยวกับความแข็งแกร่งและความจริง”

แล้วมันสมเหตุสมผลอย่างไรที่จะเผยแพร่เทคโนโลยีที่มีระดับความน่าสนใจของ ChatGPT – เป็นแอปสำหรับผู้บริโภคที่เติบโตเร็วที่สุดเท่าที่เคยมีมา – เมื่อมันไม่น่าเชื่อถือและเมื่อมี ไม่มีความสามารถในการแยกแยะ ข้อเท็จจริงจากนิยาย?

แบบจำลองภาษาขนาดใหญ่อาจเป็นประโยชน์ในการช่วย สำหรับเขียน และการเข้ารหัส. พวกเขาอาจจะปฏิวัติการค้นหาทางอินเทอร์เน็ต และวันหนึ่งเมื่อรวมกับหุ่นยนต์อย่างมีความรับผิดชอบ พวกเขาอาจได้รับประโยชน์ทางจิตใจบางอย่างด้วยซ้ำ

แต่ก็เป็นเทคโนโลยีที่อาจล่าเหยื่อได้ ซึ่งสามารถใช้ประโยชน์จากนิสัยชอบของมนุษย์ในการฉายภาพตัวตนลงบนวัตถุต่างๆ ได้อย่างง่ายดาย ซึ่งแนวโน้มดังกล่าวจะเพิ่มมากขึ้นเมื่อวัตถุเหล่านั้นเลียนแบบลักษณะนิสัยของมนุษย์ได้อย่างมีประสิทธิภาพ![]()

เกี่ยวกับผู้เขียน

เนียร อีสิโควิทศาสตราจารย์ปรัชญาและผู้อำนวยการศูนย์จริยธรรมประยุกต์ UMass บอสตัน

บทความนี้ตีพิมพ์ซ้ำจาก สนทนา ภายใต้ใบอนุญาตครีเอทีฟคอมมอนส์ อ่าน บทความต้นฉบับ.